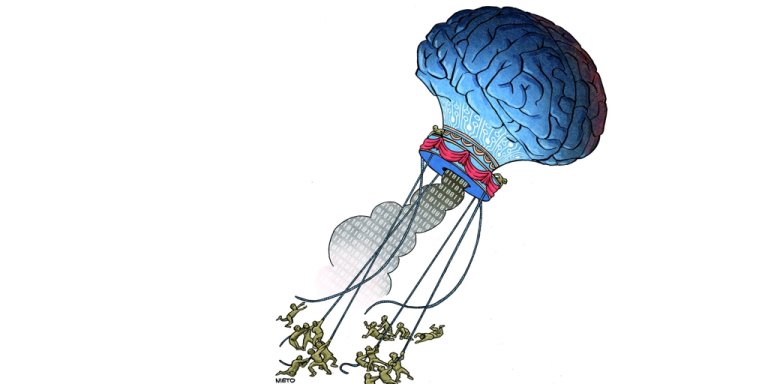

«Si esta tecnología sale mal, puede salir bastante mal». Hace un par de semanas, Sam Altman , el último treintañero revolucionario de ese pozo sin fondo llamado internet, utilizó esas palabras para alertar a los legisladores estadounidenses sobre la necesidad de poner el desarrollo de inteligencia artificial (IA) bajo un estricto control. Desde entonces, el director ejecutivo de OpenAI, la firma detrás de esa máquina parlante llamada ChatGPT, no ha dejado de elevar el tono de sus declaraciones y de alertar a la sociedad sobre los peligros que esconde esta tecnología. Primero, en Madrid la semana pasada , donde el joven empresario comparó los efectos potenciales de la IA con la bomba atómica y solicitó la creación de una agencia internacional, similar al Organismo Internacional de Energía Atómica de la ONU, que ate en corto a las compañías desarrolladoras. Este martes, elevó un poco más el tono en su advertencia. Junto a cientos de científicos y ejecutivos, entre ellos tres de los considerados padres de la inteligencia artificial, alertó sobre la probabilidad de que la tecnología acabe, incluso, con la vida humana . Solo hicieron falta 27 palabras en castellano: «Mitigar el riesgo de extinción por la IA debería ser una prioridad mundial junto con otros riesgos a escala social, como las pandemias y la guerra nuclear». Noticias Relacionadas estandar No Un dron militar de EE.UU. controlado por Inteligencia Artificial ‘mata’ a su operador en una simulación: «Usó estrategias altamente inesperadas» ABC estandar No La ‘app’ de ChatGPT ya está disponible en España: así puedes descargarla en tu ‘smartphone’ Rodrigo Alonso La ‘superinteligencia’ Entre los firmantes de la sentencia se encuentra José Hernández-Orallo, catedrático de Inteligencia Artificial en la Universidad Politécnica de Valencia. En conversación con ABC, señala que si no se toman cartas en el asunto, esos futuros distópicos, tan propios del cine testosterónico de ciencia ficción de los ochenta, podrían no diferir demasiado de la realidad : «No es lo que más preocupa dentro de este terreno, pero es importante tener cuidado para evitar que llegue un sistema con capacidades muy superiores a las de un ser humano y seamos incapaces de controlarlo». Hernández-Orallo apunta que «ya hemos visto cómo el Homo sapiens , hace millones de años, fue desbancando a otros homínidos» gracias a la evolución; por tanto, «si lo vemos desde ese punto de vista, el riesgo (de que la IA nos domine) existe como posibilidad. Y tenemos que entenderlo bien y tenerlo muy claro, porque no es completamente descartable». No es la primera vez que la comunidad científica alerta sobre la posibilidad de que las máquinas intenten remplazar al ser humano. A finales del año pasado, investigadores de la Universidad de Oxford y de Google compartieron un estudio en el que señalaban como «probable» un escenario en el que una futura IA ‘superinteligente’ intentaría borrar a la humanidad para tener acceso exclusivo a todos los recursos energéticos. OpenAI, mientras tanto, apunta que podríamos encontrarnos a diez años vista de la llegada de un sistema con un nivel de habilidad superior al de cualquier ser humano. Para que la aparición de esta hipotética herramienta no entrañe un peligro, la empresa de ChatGPT aboga, entre otras cosas, por llegar a acuerdos internacionales entre empresas y gobiernos que limiten el nivel de desarrollo de la IA año tras año. Acceso al arsenal Las armas autónomas , potenciadas con inteligencia artificial y con capacidad para atacar sin necesidad de que un humano apriete algún botón, llevan siendo desarrolladas por estados de todo el mundo desde hace años. Hay de todo tipo, desde drones que caben casi en la palma de la mano hasta grandes navíos y carros de combate. La posibilidad de dejar armamento nuclear a disposición de una máquina, y darle a esta capacidad para decidir por su cuenta y riesgo si debe activarse, también resulta preocupante. «Cuando se lanza la primera bomba nuclear tenemos claro qué es lo que va a pasar. Con la inteligencia artificial no tenemos esa certidumbre. Hay muchas cosas que no están claras, muchos escenarios preocupantes que no son descartables, por eso es importante que seamos prudentes y sigamos investigando», zanja Hernández-Orallo. Empleos en riesgo Más allá de la extinción humana, el desarrollo de la inteligencia artificial puede dibujar otros escenarios distópicos para la sociedad. Uno de los más evidentes: la destrucción de puestos de trabajo. De acuerdo con un estudio de Goldman Sachs, la inteligencia artificial podría eliminar de un plumazo hasta 300 millones de empleos , que dejarían de ser necesarios gracias a la automatización de los procedimientos en todo tipo de empresas. De acuerdo con un estudio de OpenAI, la mayoría de trabajos con pocas probabilidades de verse impactados por el desarrollo de los algoritmos son eminentemente físicos y manuales : carpinteros, albañiles, camareros o cocineros, por ejemplo. «Las empresas deben tener muy claros los problemas sociales que pueden provocar. Una cosa es poder utilizar una máquina para mejorar el rendimiento, y otra aumentar el desempleo», explica Ulisés Cortés, catedrático de Inteligencia Artificial de la Universidad Politécnica de Cataluña. «Si las máquinas mandan a mucha gente al paro, lo que pasará es que se perderá competitividad económica. Las compañías tendrán que decidir si quieren un mundo menos humano, o mantenerla armonía social», remata el docente. Control social La inteligencia artificial lleva años siendo empleada de forma activa para el control social y policial en países de todo el mundo. China, por ejemplo, lleva tiempo estudiando el desarrollo e implementación en espacios públicos de nuevas tecnologías que permitirían al estado predecir la comisión de delitos y la realización de protestas. Y todo gracias al uso de una vasta cantidad de datos recopilados sobre los hábitos de sus 1.400 millones de ciudadanos y al empleo de herramientas de reconocimiento facial, en boga en el país, que es el mayor exportador mundial de este tipo de tecnología. Estos sistemas, que en China han sido testados con el fin de detectar las emociones de las minorías musulmanas para su control, también han sido utilizados con fines policiales en otros países. Por ejemplo, en Estados Unidos, en 2020, un hombre afroamericano fue arrestado en la ciudad de Detroit después de que un algoritmo lo señalase por error como el culpable de un atraco en una tienda de lujo de la localidad. Ofelia Tejerina, jurista especializada en asuntos digitales y presidenta de la Asociación de Internautas, destaca que la Unión Europea está trabajando para regular esta tecnología para que no pueda ser empleada para clasificar a la sociedad, por ejemplo, en base a su etnia, género o estado emocional. En el resto del mundo, la historia es bien distinta. «Me preocupan mucho los sesgos y la probabilidad de error de estas máquinas. También los efectos legales que puede tener en una persona el que un algoritmo, que puede equivocarse, lo señala como culpable de un acto delictivo», zanja la jurista. Caos en internet Actualmente, en España hay varios algoritmos que se ocupan de tomar de decisiones que afectan notablemente a la vida de los ciudadanos. Ese es, por ejemplo, el caso de VioGén , sistema basado en inteligencia artificial que detecta el riesgo de reincidencia en casos de violencia de género. Durante una auditoría externa de su algoritmo, realizado por la fundación Éticas el año pasado, se descubrió que, aunque el sistema recomienda la revisión humana de las decisiones que toma, estas se mantienen en el 95% de los casos. «Si quitas al humano de la ecuación y dejas que sea un sistema el que se ocupa de todo, estas expuesto a la máquina, y si esta no está bien entrenada con los principios éticos de inclusividad, y demás, acabamos en manos de una máquina corrupta», señala Inma Martínez, presidenta del Comité de Expertos de la Asociación Global para la IA, una agencia dependiente de la OCDE y del G7. La inteligencia artificia también tiene un gran potencial en el campo de la desinformación. Herramientas como ChatGPT pueden ser activamente explotadas, y, además, con muy bien resultado, para la generación de desinformación; que luego puede ser utilizada por el país de turno para causar el caos en periodos electorales de estados antagonistas. El desarrollo de soluciones como DALL-E o Midjourney , que permiten que cualquier usuario genere imágenes falsas de gran realismo a partir de un puñado de palabras, pueden representar también una potencial amenaza para la democracia. ChatGPT, así como soluciones similares, también pueden ser explotadas para la creación de ciberestafas e, incluso, código malicioso, tal y como varias empresas informáticas e, incluso, la Europol, han alertado. Esto, como señala Hervé Lambert, jefe de operaciones de Panda Security, puede desencadenar la democratización del cibercrimen a gran escala: «Cualquier persona sin grandes conocimientos podrá secuestrar una compañía».

¿Y si el día del juicio final lo decide una máquina? Así puede extinguirnos la Inteligencia Artificial